跨节点(Worker)部署的分布式深度神经网络(DNN)训练系统已广泛应用于各个领域,而Worker之间同步梯度张量的通信开销往往成为性能瓶颈。为了优化通信效率,最先进的研究通常采用两种优化技术:i)梯度稀疏化压缩,即将梯度截断为最大的元素,以减少通信流量;ii)张量融合,将多个梯度张量合并在一个融合缓冲区内一起传输,以减少通信启动开销。然而,进过测量发现现有的研究往往在张量融合后才进行梯度稀疏化(称之为“张量融合后的稀疏化”),这就导致稀疏化后会遗漏大量融合后的梯度张量,从而影响收敛性能。

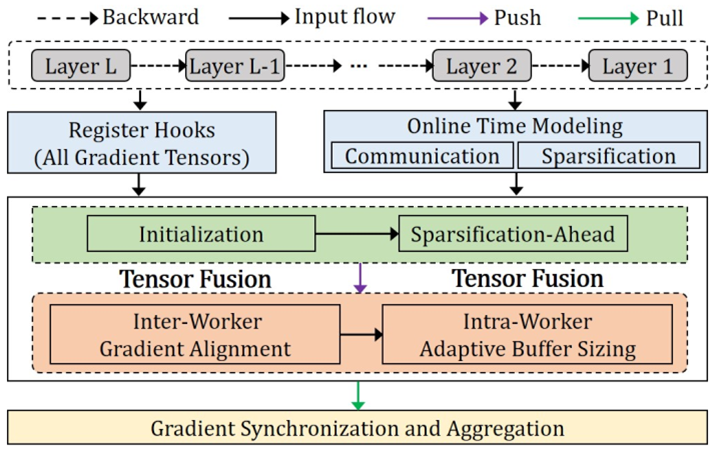

实验室博士生明章强,在胡燏翀教授的指导下,针对以上问题,为高性能分布式DNN训练提出了一种新的张量融合机制,称为SAFusion,它在张量融合过程中,先对每个梯度张量进行稀疏化处理,然后再进行合并,而不是行张量融合后再稀疏化,从而避免梯度张量缺失以提高收敛性能。此外,本文还发现 SAFusion 将面临两个局限:在张量融合过程中,不同Worker之间的同步等待时间较长以及每个Worker内部存在多个等待空闲,因此本文进一步提出了两种高效的张量融合方案来解决这两个局限:机间梯度对齐融合方案和机内自适应缓冲区融合方案。

SAFusion的工作流程

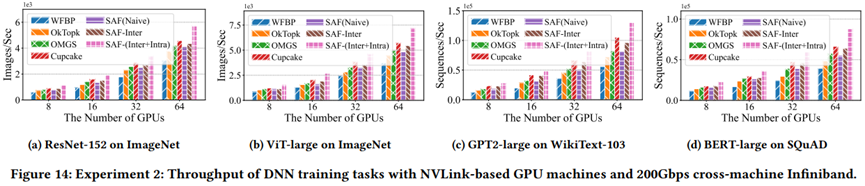

本文实现了SAFusion原型系统,在本地和云集群上进行的实验表明,SAFusion比不执行张量融合的基准稀疏化压缩方案提高了49.71%-144.42%的训练吞吐量,比最先进的张量融合方案提高了18.96%-60.89%的吞吐量,同时保持了与未压缩基线大致相同的收敛性能。

不同训练任务上的收敛性能对比

不同训练任务上的训练吞吐量对比

该研究成果以“SAFusion: Efficient Tensor Fusion with Sparsification Ahead for High-Performance Distributed DNN Training”为题,被HPDC 2025录用。本届会议共收到136篇投稿,共录用25篇论文,录用率约为18.3%。该研究工作得到了国家自然科学基金面上项目(No. 62272185)和深圳市科技计划项目(No. JCYJ20220530161006015)的支持。